前言小记#

筆者近半年由于失恋导致更新欲低下,后来又跟随课题组研究了图像识别与算法分析、自动驾驶路径规划、智能汽车控制算法,导致更新停滞。归功于 Computer Science 院长的栽培以及近期热门方向的讨论,要求我做一期 大模型 相关的技术分享,我才想起来更新博客。

本期博客,我将围绕三个话题展开:

- 从云算力到端侧算力。

- AI 时代的数据隐私。

- AI 时代的算力需求

内容包含了最新的 QwQ、大语言模型训练方法、EXO 基于网络的算力共享、全球算力统计

从云算力到端侧算力#

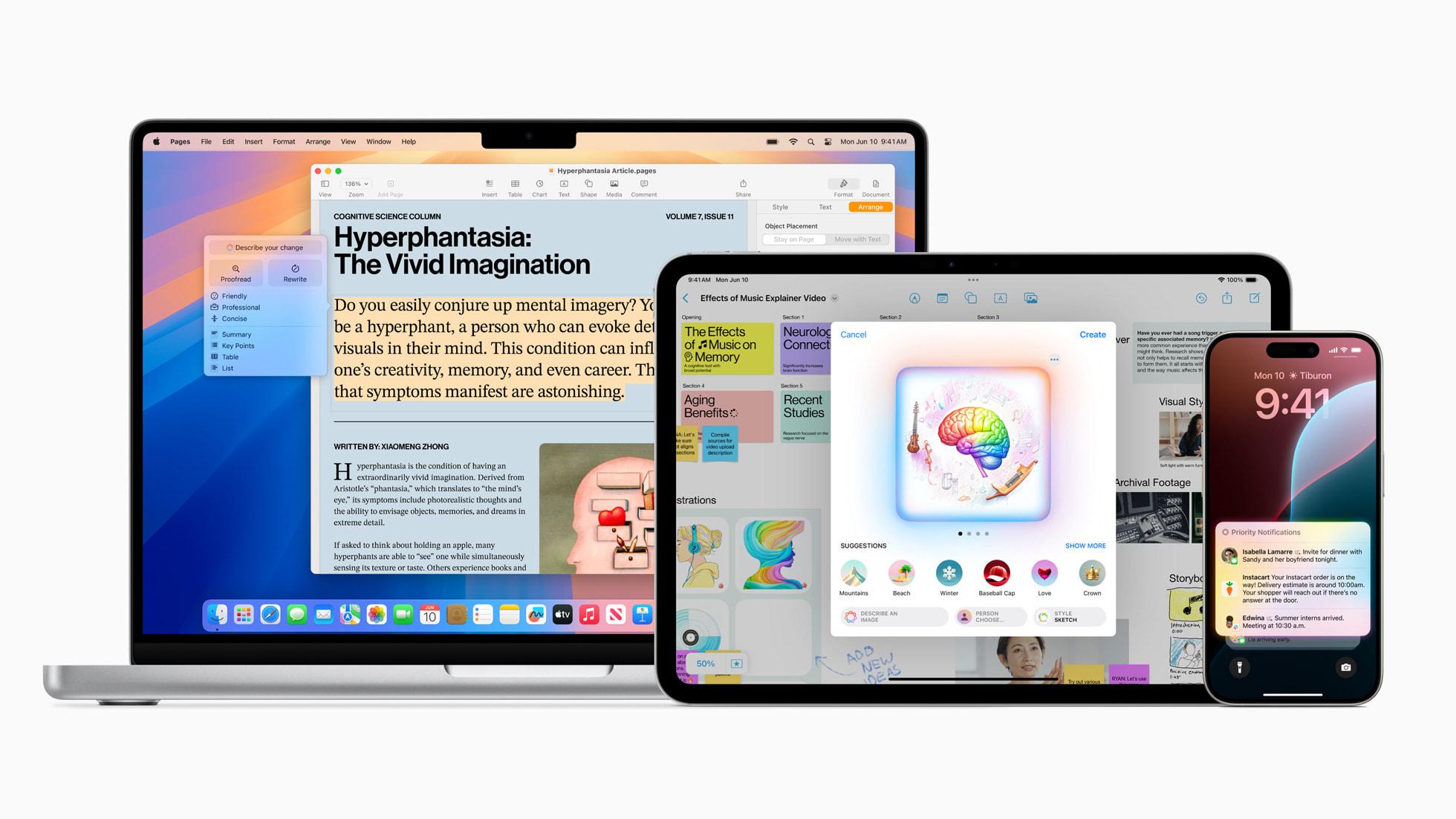

让我们使用 Apple 公司的产品 Apple Intelligence 引入这个话题

2024 年 6 月 在世界开发者大会上 Apple 公司宣布:

个人智能化系统 Apple Intelligence 为 iPhone、iPad 和 Mac 引入强大的生成式模型

语音助手作为最典型的自然语言大模型应用场景,在 ChatGPT 爆火以后,华为、小米 以及很多家公司都纷纷开始训练和发布自己公司基于大语言模型的语音助手,而 Apple 公司则是宣布接入 GPT,但由于大陆地区的政策原因,Apple 的 AI 功能时至今日都无法在大陆地区正常使用。

直到今年 2 月份

Apple 公司将为中国地区的 iPhone 等设备集成 阿里巴巴的大语言模型 以及 其它人工智能服务 Apple 宣布接入 Alibaba 的 AI 大模型用于国行 Apple 产品。

CNBC

想必当时的大家一定是一头雾水,当时正是 Deepseek 爆火的时候,为什么 Apple 不选择接入 Deepseek 这个开源大模型,而是选择了阿里的 Qwen 系列?在 Apple 做出这个决定的时候,甚至股票一度暴跌。NVIDIA 就是因为 Deepseek 导致了自己公司的股价暴跌的呀,为什么 Apple 会做出这个决定?

回答这个问题之前,先把目光放到 Deepseek 上。它性能十分强大,他的优点是开源,而且轻量,比起其它闭源模型来说,仅仅 671B 参数就足以与世界上最先进的模型不分伯仲。但是部署它需要多少显存呢?

整整 700G!如果我们想部署一个输出速度正常的 Deepseek R1 617B 版,我们可能需要大概 700G 的显存,大概 10 张 A100 显卡,成本可能需要 200 万。

虽然说它相较于当初 GPT3.5、GPT4.0 所需要的算力已经大大减少了,因为那个时候 GPT 还只能在云端使用,它所依赖的是 OpenAI 公司背后所拥有的庞大算力集群,这对于一般的企业可以说是望尘莫及的。但是好在 OpenAI 的产品推动了这方面的革命,让 Deepseek 得以诞生,也归功于 Deepseek 的开源,让更多的新模型足以站在伟人之肩,这时候 QwQ 诞生了!

2025 年 3 月 6 日,阿里的千问团队 重磅发布 QwQ 开源大模型,参数量仅 32B!

强大的 QwQ 以 32B 的少量参数(在大模型里算是)就足以媲美 Deepseek R1 671B 满血版,甚至超越了 Deepseek!QwQ 回应了 Apple 选择阿里的原因,对于个人用户只需要一张 4090 显卡就可以运行,成本从 200 万一步压缩到了 2 万。可事实是这样吗?近期媒体都在吹捧,可事实是……?

阿里团队是这样描述 QwQ 的:

这是一款拥有 320 亿参数的模型,其性能可与具备 6710 亿参数(其中 370 亿被激活)的 DeepSeek-R1 媲美

《QwQ-32B: 领略强化学习之力》

没错 QwQ 仅仅与 激活了 370B Deepseek 做了性能比较…………………… 吗?

架构#

我在技术研讨会上并未提及的事情就是, QwQ 仅仅与激活了 370B Deepseek 做了性能比较,但这正是我要讲的一大重大部分,Deepseek 以及基于其方式的 QwQ 模型的架构问题。(因为分享会邀请了两个非专业的老师和群众旁听,并且向我们提问,因此我必须讲的简单易懂,分享会时减去了很多细节内容)

归功于 Dense 架构,消费级计算设备就足以运行 QwQ,而 Deepseek 则是 MoE 架构,或者说 Hybrid MoE 混合专家架构,基于结果来看似乎 Dense 架构会好一点?实则不然,需要从架构细节讲起。

这两种架构有何区别?

Mixture of Experts(MoE)模型是一种通过将模型分成多个专家子网络,并根据输入数据的特点,动态选择合适的专家进行计算的架构。每个 “专家” 都在某个领域拥有强大的处理能力,而 MoE 则根据任务需求智能选择合适的专家进行运算。这一机制在保证较小计算开销的同时,能够显著提升模型的表达能力和灵活性。尤其在面对大规模数据集时,MoE 模型通过精确地选择不同的专家来处理特定的任务,从而避免了冗余计算,并有效地降低了资源消耗。

大段长描述看着很费劲,简单的说,就是 MoE 架构设计,就是使得 AI 功能特异化,一定类型的事情,交由指定的 “专家” 模块处理,这也是 Deepseek 在推理只激活了大约 370B 的原因。

相对于 MoE 模型,Dense 模型则是传统的深度神经网络架构。Dense 模型的设计理念非常简单 —— 每个神经元(或计算单元)都参与到每个计算中。无论任务的难易程度,Dense 模型的每个参数都会参与到每次的计算中。这使得 Dense 模型在处理相对较简单的任务时能够表现得较为稳定,但在面对复杂问题时,Dense 模型却显得有些力不从心。

因为 Dense 模型没有像 MoE 那样智能选择合适的计算单元,所以每次训练时,都需要对所有参数进行计算和更新,这带来了巨大的计算量和存储需求。因此,Dense 模型的计算成本较高,尤其是在处理大规模数据集或复杂任务时,效率会大大降低。

简单的说,Dense 架构就是所有参数一拥而上,力大砖飞

前面说从结果上来看 Dense 架构更胜一筹,但从架构上来看分明是 MoE 架构更胜一筹才对,可是为什么 QwQ 使用 Dense 架构却超越了 MoE 架构的 Deepseek?

从性能需求讲起,MoE 架构得益于分任务于各个专家模型使其获得了强大的计算推理能力,但!!!!它对硬件的要求极高,它需要十分强大的并行计算能力。而 Dense 架构则恰恰相反,即使是 CPU + 内存的运行模式,都不会使它的运行效率变得奇低。

MoE 就相当于娇生惯养的超级学神,而 Dense 则恰恰是超级好养活的萌娃。

综合来说,小参数模型采用 Dense 架构,可以提高质量,而大参数模型采用 MoE 则可以提升效率。

除开 小体量参数 弥补了 QwQ 在 Dense 架构上的不足,更重要的是他的训练方式。

技术详解#

QwQ 发布页的标题是这样写的:领略强化学习之力

Qwen 团队解释到:近期的研究表明,强化学习可以显著提高模型的推理能力。例如,DeepSeek R1 通过整合冷启动数据和多阶段训练,实现了最先进的性能,使其能够进行深度思考和复杂推理。

介于 QwQ 的技术报告至今依旧很少,但是它基于 Deepseek 的模式进行了训练,因此我们可以结合部分 Deepseek 的训练方式来解读为何 QwQ 拥有如此强大的性能。

QwQ-32B 的训练过程分为三个阶段:预训练、监督微调和强化学习,其中强化学习又分为两个关键阶段,让 QwQ 实现了超越 Deepseek 的性能。

要解读原因,让我们来逐步解读什么是 “冷启动”?何为强化学习?有哪两个关键阶段?

“冷启动”

为了帮助大家更好的理解冷启动,让我举一个日常生活的例子。

大数据推荐算法

推荐算法会根据每个用户的喜好推荐视频、商品等

但首次注册的新账号是不具备先前累积数据的,系统就无法进行精确推荐

这就是 “冷启动”

大模型在冷启动时,会像一个 “什么都不会的孩子”,不断犯错,生成一堆毫无逻辑的答案,甚至可能陷入无意义的循环。

使用 “冷启动数据”,在 AI 训练的早期阶段,先用小批高质量的推理数据微调模型,相当于给 AI 提供一份 “入门指南”。

参考 Deepseek 优化冷启动步骤:

- 从大型模型生成数据 – 研究人员使用少样本提示。

- 从 Deepseek R1 Zero 生成数据 – 由于 R1-Zero 具备一定的推理能力,研究人员从中挑选出可读性较好的推理结果,并重新整理后作为冷启动数据。

- 人工筛选和优化 – 人工审查部分数据,优化表达方式,使推理过程更加直观、清晰。

最终,DeepSeek-R1 使用了数千条冷启动数据来进行初步微调,然后再进行强化学习训练。

强化学习#

其他机器学习方法主要是 监督学习 和 无监督学习,而强化学习是除了监督学习和无监督学习之外的第三种机器学习范式

强化学习的特点总结为以下四点:

- 没有监督者,只有一个奖励信号

- 反馈是延迟的而非即时

- 具有时间序列性质

- 智能体的行为会影响后续的数据

四个基本要素

强化学习系统一般包括四个要素:策略(policy),奖励(reward),价值(value)以及环境或者说是模型(model)。接下来我们对这四个要素分别进行介绍。

策略(Policy)

策略定义了智能体对于给定状态所做出的行为,换句话说,就是一个从状态到行为的映射,事实上状态包括了环境状态和智能体状态。我们将策略的特点总结为以下三点:

- 策略定义智能体的行为

- 它是从状态到行为的映射

- 策略本身可以是具体的映射也可以是随机的分布

奖励(Reward)

奖励信号定义了强化学习问题的目标,在每个时间步骤内,环境向强化学习发出的标量值即为奖励。我们将奖励的特点总结为以下三点:

- 奖励是一个标量的反馈信号

- 它能表征在某一步智能体的表现如何

- 智能体的任务就是使得一个时段内积累的总奖励值最大

价值(Value)

价值,或者说价值函数,这是强化学习中非常重要的概念,与奖励的即时性不同,价值函数是对长期收益的衡量。我们常常会说 “既要脚踏实地,也要仰望星空”,对价值函数的评估就是 “仰望星空”,从一个长期的角度来评判当前行为的收益,而不仅仅盯着眼前的奖励。我们将价值函数的特点总结为以下三点:

- 价值函数是对未来奖励的预测

- 它可以评估状态的好坏

- 价值函数的计算需要对状态之间的转移进行分析

环境(模型)

外界环境,也就是模型(Model),它是对环境的模拟,当给出了状态与行为后,有了模型我们就可以预测接下来的状态和对应的奖励。我们将模型的特点总结为以下两点:

- 模型可以预测环境下一步的表现

- 表现具体可由预测的状态和奖励来反映

强化学习架构

两大关键阶段#

强化学习第一阶段

聚焦于数学和编程能力的提升。从冷启动检查点开始,基于结果的奖励驱动的强化学习扩展方法。

数学问题训练,模型使用专门的准确性验证器,而非传统奖励模型

编程任务训练,用代码执行服务器评估代码是否通过预定义测试用例

强化学习第二阶段

侧重通用能力增强

模型引入通用奖励模型和规则验证器进行训练。

即使是少量的训练步骤,也显著提升了指令跟随、人类偏好对齐和智能体性能,并且实现通用能力提升的同时,不显著降低第一阶段获得的数学和编程能力

依靠这些技术 使得 QwQ 模型足以四两拨千斤,与 MoE 大参数模型不分伯仲也使得算力从云端来到了端侧(本地)但是为什么致力于将云计算模式放回端侧,追求低算力需求的高效模型,开展本地计算模式呢?

AI 时代的数据隐私#

我们每人每天都会在互联网上留下大量数据

这些数据又有绝大多数涉及隐私性问题

在 AI 时代如何保护个人隐私数据也成了一大难点

Apple 公司从很早以前就开始注重用户的数据隐私

他们着重保护的就是用户的数据隐私,甚至华为的专家写了上万字解析 Apple 公司的数据隐私保护策略

个人用户不可能在本地拥有庞大的算力集群,目前个人用户使用大模型功能的唯一途径就是链接云端,这对于数据隐私来说,是一个十分严峻的挑战

比如之前就有地区禁止 Tesla 汽车,担心道路数据交由境外处理,这是一系列敏感问题,我们十分担心这些 使用 AI 的数据被传输到非法目的、有损国家利益的反面去,所以对于数据安全的保护,至关重要

端侧运行大模型,可以降低成本、提升隐私数据保护性,因此需要模型有更高的效率

如果模型足够高效,就可以同等算力下,在端侧做到更多、更加高精度的事情

未来 AI 的发展方向之一应当像 QwQ 一样,更高的效率、更低的端侧算力需求

AI 时代的算力需求#

得益于 AI 技术的发展,我们已经可以使 AI 模型运行在本地,并且使用 CPU + 内存的模式进行计算,开源项目 EXO 通过网络的方式,将 AI 模型的多个层分散到不同的设备上运行,以此共享算力,使得 AI 运行成本再次降低。

但这仅仅是可供运行,无法做到高效运行 以及 AI 训练,要做到这些 我们依旧需要极高的算力。

之前提到过所有的大模型及其训练方式,均无法脱离 “算力” 的支持,无论是强大的 Deepseek 还是高效的 QwQ 都无法摆脱算力的支持不,管是 700G 的显存需求,还是消费级 4090 显卡甚至是使用 CPU 计算 都是依赖的算力资源

全球电力需求数据对比#

| 年份 | 全球电力需求 | 主要变化与趋势 |

|---|---|---|

| 2019 | 约 25,000 TWh | 中国电力需求增速预计为 5%,全社会用电量约为 7.28 万亿 - 7.41 万亿千瓦时 |

| 2024 | 约 30,000 TWh | 主要受数据中心和 AI 训练需求驱动。谷歌和微软的数据中心电力消耗均达到 24 TWh,比 2019 年翻一番 |

全球 AI 算力需求数据对比#

| 年份 | 全球 AI 算力 | 主要变化与趋势 |

|---|---|---|

| 2019 | 约 10¹⁸ FLOP/s | AI 算力主要由传统 GPU 和 TPU 提供,算力增长相对平稳,尚未进入爆发期 |

| 2024 | 约 10²¹ FLOP/s | AI 算力显著提升,全球机器学习硬件性能以每年 43% 的速度增长,顶级硬件能效每 1.9 年翻一番,谷歌拥有超 100 万 H100 等效算力,全球 NVIDIA 支持的计算能力平均每 10 个月翻一番 |

各大公司 2025 年预计投入资金#

| 公司 | AI 算力 (等效 H100) | 经费支出 | 主要变化与趋势 |

|---|---|---|---|

| 谷歌 | 超 100 万 | 750 亿美元(约 5400 亿元) | 用于 AI 基础设施 |

| 微软 | 75 万 - 90 万 | 800 亿美元(约 5760 亿元) | 用于 AI 数据中心建设,主要用于训练 AI 模型和部署 AI 应用 |

| 阿里 | 23 万(英伟达 GPU) | 1500 亿元 | 主要用于 AI 和云计算基础设施建设 |

| 腾讯 | 23 万(英伟达 GPU) | 820 亿元 | 用于智算中心,主要用于显卡服务器和网络建设 |

不难看出,随着 AI 的井喷式发展,全球对算力的需求达到了前所未有的高度,同时电力需求也愈发增大,各大厂商也在加紧占领 算力 高地,算力对 AI 时代的重要性可见一斑。

与此同时,甚至出现了 “算力 = 国力” 的论调!

此文由 Mix Space 同步更新至 xLog

原始链接为 https://fmcf.cc/posts/technology/AIComputingPower